Le biais dans l’intelligence artificielle

Introduction

Comme nous l’avons vu précédemment, les données, les algorithmes et l’intelligence artificielle influencent d’ores et déjà de nombreux aspects de notre vie, que ce soit d’un point de vue privé ou professionnel. On leur confie de plus en plus de problématiques et pour des raisons d’efficacité, de productivité ou de rapidité d’exécution, nous les laissons analyser nos informations, les interpréter et prendre des décisions en notre nom ou au nom de nos entreprises.

Alors que nous devenons de plus en plus dépendants aux technologies et à l’intelligence artificielle, il devient nécessaire et légitime de se poser la question des risques d’une telle dépendance et surtout comprendre ce qu’est l’IA et comment, aujourd’hui, elle fonctionne. Plus encore au regard de l’aura d’objectivité et d’infaillibilité que notre culture attribue à celle-ci. En effet, pour beaucoup, les algorithmes développés sont considérés comme déterministes, impartiaux, neutres et incorruptibles et sont rarement remis en cause, d’autant plus qu’ils s’appuient sur une science avérée : les mathématiques.

Pourtant, et nous le verrons plus précisément dans ce chapitre...

Qu’appelle-t-on biais ?

Le biais qui vient du latin populaire biaxius, signifiant qui a deux axes, peut avoir deux sens. Celui d’une ligne oblique, d’une diagonale et celui d’un moyen détourné qui nous intéressera dans ce chapitre.

Dans diverses disciplines, un biais est une erreur systématique ou une simplification abusive. Ainsi, il existe de nombreux types de biais, les deux listés ci-dessous, qui seront ceux que nous allons considérer dans la suite de ce chapitre, possèdent aussi leur propre sous-ensemble de biais.

-

Le biais cognitif qui est une déviation dans le traitement cognitif d’une information qui conduit à de mauvaises interprétations.

-

Le biais algorithmique qui est le fait que le résultat d’un algorithme d’apprentissage ne soit pas neutre, loyal ou équitable.

Comme les humains, les intelligences artificielles qui utilisent les données, qui suivent des processus et des méthodes et qui sont basés sur des algorithmes, sont sujets aux biais. Des décisions doivent être prises avec des informations imparfaites, incomplètes ou erronées, en s’appuyant sans le savoir sur certains préjugés.

Par exemple, faire plus confiance à quelqu’un s’il est une figure d’autorité, supposer le sexe de quelqu’un en fonction de sa profession, faire de mauvaises interprétations et prendre de mauvaises décisions sur la base des informations...

Le biais et l’intelligence artificielle

En intelligence artificielle, deux biais majeurs peuvent être considérés, le biais de code et le biais des données.

Le biais de code est introduit par le concepteur du code, qu’il soit programmeur, analyste-programmeur ou plus généralement concepteur du code. Il faut rajouter humain ou non humain, puisqu’aujourd’hui des intelligences artificielles sont capables de créer et générer des programmes informatiques.

Le biais de code comprend le biais algorithmique, le biais mathématique et le biais cognitif du concepteur du code.

Une nouvelle technologie appelée Codex génère des programmes dans 12 langages de programmation et les traduit même entre eux.

Le biais des données est créé lorsque les données récupérées et utilisées sont, incomplètes, inappropriées, obsolètes, ou invalides. La responsabilité peut être partagée entre les programmeurs, les concepteurs du système, les data scientists ou tout autre tiers (humain ou pas) qui introduit sciemment ou pas des données erronées.

Le biais est apparu en intelligence artificielle en même temps que l’apprentissage. Ce qu’une entité artificielle apprend est lié à la validité de l’enseignement qui lui est fourni. Enseignez des informations fausses à une IA et elle effectuera des actions et prendra des décisions inadaptées. En effet, les données servent à la création des modèles utilisés par les intelligences artificielles pour leur apprentissage. Les biais de l’IA sont des biais qui reflètent les préjugés de ses créateurs ou de ses données.

Il faudra considérer le biais conscient ou inconscient, c’est-à-dire des erreurs dans le code ou dans les données, introduites de manière volontaire ou pas. On peut y trouver toutes sortes de cause : hacker, pirate informatique, délinquant, terroriste, perturbation magnétique, matériel ou logiciel déficient, mauvaises spécifications erreur humaine ou non humaine, erreur d’apprentissage, modèle obsolète, etc.

1. Le code est-il biaisé ?...

Les risques liés aux biais

Cette section s’intéresse aux risques liés aux biais dans l’intelligence artificielle. C’est-à-dire quel peut être l’impact de codes biaisés ou de données biaisées.

Même si les risques liés aux biais en sont un sous-ensemble, il n’est pas question ici de s’intéresser aux risques directement liés à l’intelligence artificielle, dont certains aspects seront détaillés dans le chapitre sur l’impact de l’intelligence artificielle sur les métiers. En effet, nous aborderons dans cette section, les risques liés aux biais dans le monde de l’intelligence artificielle, c’est-à-dire essentiellement liés à la création des modèles et de l’apprentissage automatique des machines.

1. Les niveaux de risques

De nombreuses entreprises se tournent vers l’apprentissage automatique pour examiner de grandes quantités de données, de l’évaluation du crédit pour les demandes de prêt à la recherche d’erreurs dans les contrats légaux, en passant par l’examen des communications des employés avec les clients pour identifier les mauvaises conduites. Néanmoins si les algorithmes d’apprentissage automatique permettent aux entreprises de réaliser de nouveaux gains d’efficacité et de productivité, ils sont aussi sensibles, comme n’importe quel autre système, au syndrome vu précédemment...

La prévention

La prévention des biais nécessite une approche proactive de la recherche des biais. Réagir face à des problèmes plus ou moins graves engendrés par des biais est essentiel, voire obligatoire, mais prévenir ceux-ci, est plus efficace et beaucoup moins impactant pour l’entreprise.

En intelligence artificielle où l’apprentissage automatique des machines est fréquent, les problèmes engendrés par les biais de codes, de variables ou de données peuvent ne pas être vus facilement et générer, comme nous l’avons vu au début de cette section, des risques importants pour l’entreprise.

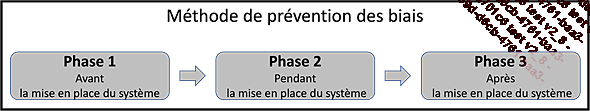

La méthode que j’ai élaborée s’appuie sur trois phases séquentielles majeures dans la prévention des biais.

|

1. |

Avant la mise en place du système : les spécifications, le choix des sources de données, le choix des données, le choix des variables, la validation. |

|

2. |

Pendant la conception du système : le choix des algorithmes, la finalisation du choix des variables, le langage de programmation, l’environnement, la construction du modèle, les tests et analyse des résultats. |

|

3. |

Après la mise en place du système : la surveillance du système, l’analyse des résultats et la détection des biais, la correction. |

Ces trois étapes n’ont pas la même fréquence d’exécution :

-

La phase 1 sera exécutée au démarrage du projet et sera exécutée chaque fois qu’un des composants établis à cette étape (spécifications, sources des données, données, variables) est susceptible de changer.

-

La phase 2 sera exécutée chaque fois que le modèle devra être modifié, la détection étant faite lors de l’exécution de l’étape 3.

-

La fréquence d’exécution de la phase 3 est à définir, mais on peut considérer qu’elle s’effectue en continu.

Les trois phases de la prévention des biais

1. Avant la mise en place du système

Cette phase définit ce qui doit être fait avant le développement du système. Trois étapes...

Les logiciels et les outils

La liste, triée par ordre alphabétique, des outils et des logiciels décrits dans ce chapitre ne se veut pas exhaustive, mais elle est un état des lieux de ce qui est utilisé le plus fréquemment aujourd’hui dans les entreprises. L’intérêt est de connaître ce qui existe et au regard des besoins mentionnés dans les chapitres précédents, répertorier les différentes fonctionnalités qui pourraient les couvrir.

Il est à noter que la prévention, détection et correction de biais est aujourd’hui un domaine où la recherche est très présente. Quelques articles intéressants sont fournis dans les sources de ce chapitre.

AI Fairness 360 (IBM) : cette boîte à outils open source extensible peut vous aider à examiner, signaler et atténuer la discrimination et les biais dans les modèles d’apprentissage automatique tout au long du cycle de vie de l’application d’IA. Dix algorithmes d’atténuation des biais à la pointe de la technologie sont disponibles et peuvent traiter les biais dans les systèmes et l’utilisateur peut compléter cet ensemble avec ses propres algorithmes. Les métriques d’AI Fairness (plus de 70 à ce jour) sont disponibles dans le référentiel GitHub. De nombreux tutoriels sont disponibles afin de mieux répondre à vos besoins. https://aif360.mybluemix.net

Anthropic (https://www.anthropic.com) : l’objectif de la start-up est d’aider à concevoir des algorithmes d’intelligence artificielle plus fiables et compréhensibles. Fondée par des anciens d’OpenAI, elle mène des recherches autour de l’explicabilité de l’IA avec la construction d’algorithmes fiables, interprétables et orientables. Anthropic souhaite bâtir une infrastructure expérimentale à grande échelle pour explorer et améliorer les propriétés de sécurité des modèles d’intelligence artificielle pour le calcul intensif. Son deuxième...

Des exemples d’impact du biais

Les exemples de problème dus aux biais de code ou de données sont nombreux. Bienheureusement, les entreprises sont aujourd’hui conscientes de la problématique et beaucoup d’entre eux ont été ou sont en passe d’être corrigés. Aussi, il m’est impossible d’être exhaustif en la matière et je résumerai dans cette section quelques-uns des exemples ou risques répertoriés les plus fréquents.

Juridique :

-

Correctional Offender Management Profiling for Alternative Sanctions, COMPAS est un algorithme utilisé dans les systèmes judiciaires aux États-Unis. Son objectif est d’aider à la réforme de la justice pénale dans toutes les juridictions des États-Unis. Il est aujourd’hui utilisé dans 46 états américains, pour notamment prédire la probabilité d’une récidive criminelle et servir de guide lorsque des criminels sont condamnés. Une analyse des résultats du logiciel COMPAS a été faite par l’entreprise ProPublica dont la conclusion a été que les résultats ne sont pas mieux que ceux obtenus par des personnes non formées et choisies aléatoirement sur Internet ou que des algorithmes statistiques beaucoup plus simples. Même si la société Equivant qui a conçu et développé le logiciel conteste cette analyse, il a tout de même été constaté que des biais importants ont générés des résultats statistiques faussés en prédisant à tort que, comparés aux accusés blancs, les accusés noirs présentent un risque de récidive plus important. En effet, les accusés...

Conclusion

Les bienfaits de l’intelligence artificielle sont vantés sans demi-mesure. Et cela, d’autant plus que les technologies et processus qui la composent commencent à être réglementés en Europe. Néanmoins, les biais sont omniprésents et peuvent être à l’origine de nombreuses erreurs trop souvent discriminatoires.

Cette discrimination a été mise en évidence dans les livres de Cathy O’Neil dont certains sont référencés dans les sources de ce chapitre.

Développer une intelligence artificielle éthique et de confiance passe nécessairement par une détection et une prise en charge systématique de ces biais.

Comme nous l’avons vu dans ce chapitre, chez l’humain les biais sont naturels et même s’ils ne sont pas nécessairement négatifs, du fait de sa connaissance des environnements, du monde qui l’entoure, de son historique, de sa mémoire, des informations immédiates dont il dispose, l’humain a des préjugés et fait des raccourcis qui mènent à des raisonnements incomplets qui peuvent générer des problèmes plus ou moins graves.

La différence entre un individu biaisé et un algorithme biaisé est l’impact qu’ils ont sur la vie et sur la société. Un biais...

Sources et références

Je cite ci-dessous quelques-unes des sources que j’ai utilisées pour ce chapitre. La liste n’est pas exhaustive, mais elle recense la plus grande partie d’entre elles.

Les biais

-

Clémence Maquet, Intelligence artificielle : quelle approche des biais algorithmiques, SiecleDigital, 2021.

-

Joy Buolamwini, Shalini Kantayya, Coded Bias, Netflix, 2021.

-

Wikipedia, le biais.

-

Yann Le Cun, Quand la machine apprend, Éditions Odile Jacob, 2019.

Les risques

-

Adrienne Yapo, Joseph Weiss, Ethical Implications Of Bias In Machine Learning, Bentley University, 2018.

-

J. Angwin, J. Larson, S. Mattu, and L. Kirchner, Machine bias: There’s software used across the country to predict future criminals. and it’s biased against blacks, ProPublica, 2016.

-

Lori Witzel, 5 Things You Must Do Now About the Coming EU AI Regulation, Medium.com, 2021.

-

Parlement européen et du conseil, Règles harmonisées concernant l’intelligence artificielle, Commission européenne, 2021.

La prévention

-

Antoine Crochet-Damais, Biais algorithmique en IA : définition, exemples et techniques de lutte, JDN, 2022.

-

Officiel Prevention, La prévention des risques professionnels de l’Intelligence artificielle, 2022.

-

S. Barocas, M. Hardt, and A. Narayanan, Fairness and Machine Learning, fairmlbook.org, 2019.

-

Thomas Klierg, Stephan Bahnik, Johannes Furnkranz, A review of possible effects...

Editions ENI Livres | Vidéos | e-Formations

Editions ENI Livres | Vidéos | e-Formations